반응형

250x250

Notice

Recent Posts

- Today

- Total

DATA101

딥러닝 모델 평가 지표: ROC Curve, AUC Score 본문

728x90

반응형

1. ROC Curve

- Receiver Operating Characteristic 곡선의 약자

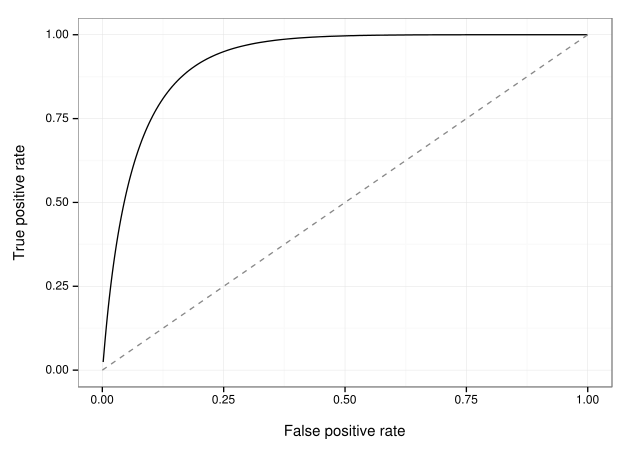

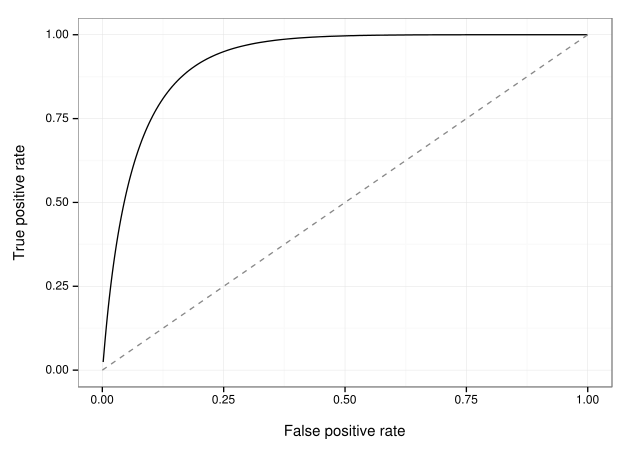

- (그림 1) \(x\)축: FPR(False Positive Rate), \(y\)축: TPR(True Positive Rate)

- FPR: 전체 경우 중 모델이 Positive로 예측했으나 실제 정답이 Negative인 비율로, 전체 경우에서 TNR(True Negatvie Rate)를 뺀 값과 같음

- $$ FPR = 1 - TNR = 1 - \frac{TN}{FP+TN}=\frac{FP}{FP+TN} $$

- TPR: 전체 경우 중 모델이 Positive로 예측했는데 실제 정답이 Positive인 비율(Recall과 동일)

- $$ TPR = Recall = \frac{TP}{TP+FN} $$

- FPR: 전체 경우 중 모델이 Positive로 예측했으나 실제 정답이 Negative인 비율로, 전체 경우에서 TNR(True Negatvie Rate)를 뺀 값과 같음

- 그림 1에서 Reference Line(i.e., 가운데 선형 직선)보다 \(y\) 값이 크고 곡선이 멀리 위치할수록 모델 성능 우수

2. AUC Score

- Area Under the ROC Curve의 약자

- ROC Curve 아래 면적 의미

- AUC 값이 \(1\)에 가까울수록 좋은 모델이며 \(0.5\)보다 커야 유의미한 모델

📚 참고할 만한 포스팅

1. 딥러닝 모델 평가 지표: Confusion Matrix, Accuracy, Precision, Recall, F1 Score, Average Precision

2. 딥러닝 모델 평가 지표: ROC Curve, AUC Score

3. Multi-label Classification 평가지표: Example-based vs Label-based Evaluation

오늘은 딥러닝 평가 모델 지표인 ROC Curve와 AUC Score에 대해 알아봤습니다.

포스팅 내용에 오류가 있다면 아래에 댓글 남겨주세요😊

그럼 오늘도 즐거운 하루 보내시길 바랍니다.

고맙습니다 :)

728x90

반응형

'AI & 빅데이터 > 머신러닝·딥러닝' 카테고리의 다른 글

| [Deep Learning] Batch Normalization(배치 정규화) 개념 및 장점 (0) | 2022.07.22 |

|---|---|

| Multi-label Classification 평가지표: Example-based vs Label-based Evaluation (0) | 2022.07.16 |

| 딥러닝 모델 평가 지표: Confusion Matrix, Accuracy, Precision, Recall, F1 Score, Average Precision (0) | 2022.07.14 |

| [딥러닝] Grid Search, Random Search, Bayesian Optimization (0) | 2022.05.23 |

| [딥러닝] 기울기 소실(Vanishing Gradient)의 의미와 해결방법 (12) | 2022.05.22 |