반응형

250x250

Notice

Recent Posts

- Today

- Total

DATA101

딥러닝 모델 평가 지표: Confusion Matrix, Accuracy, Precision, Recall, F1 Score, Average Precision 본문

AI & 빅데이터/머신러닝·딥러닝

딥러닝 모델 평가 지표: Confusion Matrix, Accuracy, Precision, Recall, F1 Score, Average Precision

DATA101 2022. 7. 14. 14:11728x90

반응형

📚 목차

1. Confusion Matrix

2. Accuracy

3. Precision

4. Recall

5. F1 Score

6. Average Precision

👨💻 들어가며

본 포스팅에서는 Binary Classification 및 Multi-class Classification에서 기본적으로 다루는 평가지표인 Confusion Matrix, Accuracy, Precision, Recall, F1 Score, Average Precision에 대해 다룹니다. Multi-label Classification에서 사용되는 평가지표는 아래의 포스팅을 참고해 주세요.

https://heytech.tistory.com/434

1. Confusion Matrix

- '혼동 행렬' 또는 '오차 행렬'이라도 부름

- 모델이 분류한 클래스(Predicted Class)와 실제 정답 클래스(Actual Class) 간 비교표(Conf., 그림 1)

- True: 모델 예측과 정답이 일치하는 경우

- False: 모델 예측과 정답이 일치하지 않는 경우

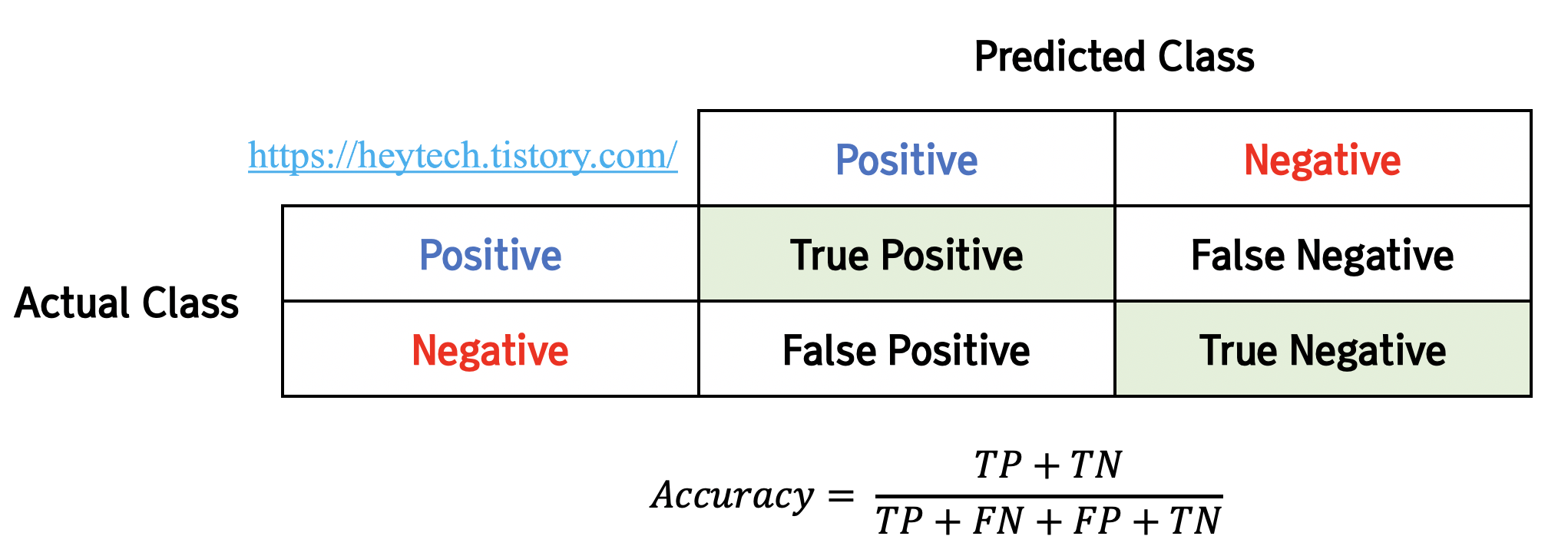

2. Accuracy

- '정확도'라고 부름

- 모델이 예측한 전체 경우 중 정확히 예측한 비율(Conf., 그림 2)

- eg., 모델이 전체 경우 중에서 스팸 메일을 스팸 메일로 분류한 경우와 스팸이 아닌 메일을 스팸이 아니라고 분류하는 경우 고려

- Accuracy 값이 클수록 모델 성능이 우수하다고 평가

- 클래스 불균형(Class imbalance) 문제를 보완할 평가 지표 필요(e.g., F1 Score)

- e.g., 100일 중에 90일 동안 맑은 날씨인 지역의 경우, 모델이 100일 모두 맑은 날씨라고 예측해도 정확도가 90%로 높게 측정

- $$ Accuracy = \frac{TP+TN}{TP+FN+FP+TN} $$

3. Precision

- '정밀도'라고도 부름

- 모델이 Positive로 예측한 것 중 정답이 Positive인 비율(Conf., 그림 3)

- e.g., 모델이 날씨가 맑을 것으로 예측한 경우 중에서 실제로 날씨가 맑은지 확인

- Precision 값이 클수록 모델 성능이 우수하다고 평가

- Recall과 trade-off(상호보완적) 관계

- $$ Precision = \frac{TP}{TP+FP} $$

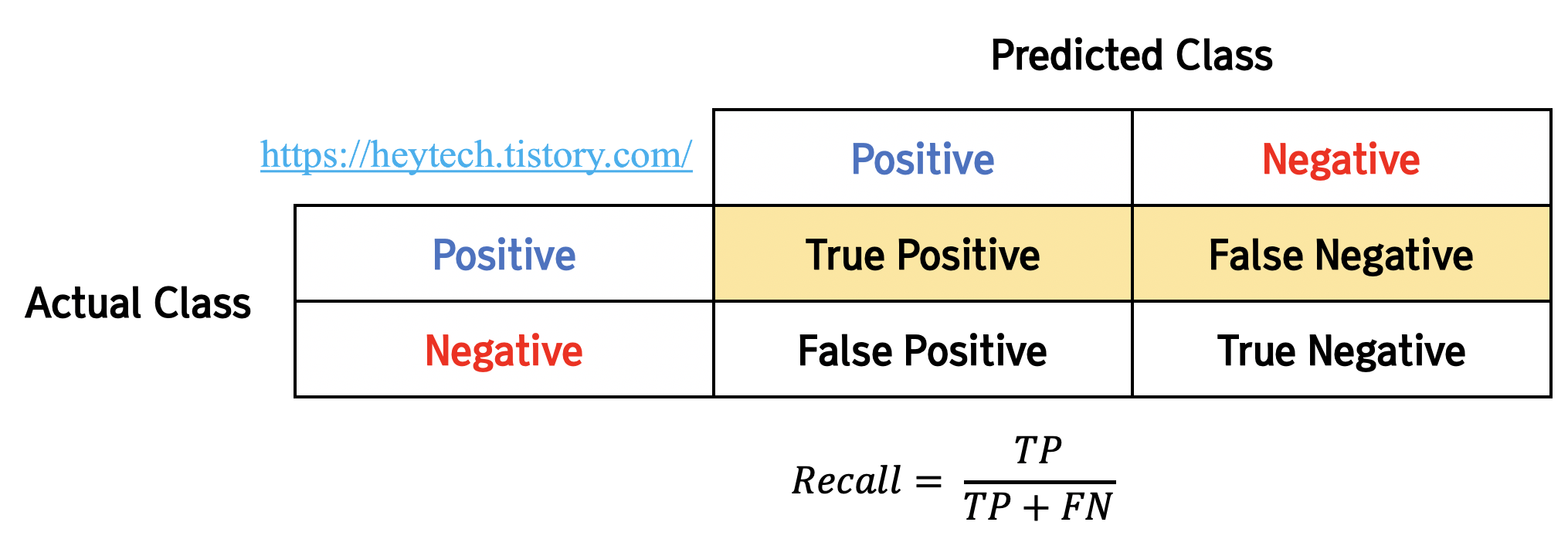

4. Recall

- '재현도', 'Sensitivity', 'hit rate'라고도 부름

- 정답이 Positive일 때 모델이 Positive로 예측한 비율(Conf., 그림 4)

- e.g., 날씨가 맑았을 때 모델이 날씨가 맑을 거라고 예측한지 확인

- Recall 값이 클수록 모델 성능이 우수하다고 평가

- Precision과 trade-off(상호보완적) 관계

- $$ Recall = \frac{TP}{TP+FN} $$

5. F1 Score

- Precision과 Recall의 조화 평균

- Class imbalance 시 모델의 성능 평가에 유용

- F1 값이 클수록 모델 성능이 우수하다고 평가

- 조화 평균 사용이유: 산술평균과 비교했을 때 Class imbalance의 bias 작음

- $$ F1 Score = 2 * \frac{1}{\frac{1}{Precision}+\frac{1}{Recall}} = 2*\frac{Precision * Recall}{Precision + Recall} $$

6. Average Precision(AP)

- Precision-Recall Curve와 \(x\)축, \(y\)축 사이의 면적을 의미

- Average Precision 값이 클수록 모델 성능이 우수하다고 평가

* 그림 5 출처

Felzenszwalb, P. F., Girshick, R. B., McAllester, D., & Ramanan, D. (2010). Object detection with discriminatively trained part-based models. IEEE transactions on pattern analysis and machine intelligence, 32(9), 1627-1645.

포스팅 내용에 오류가 있다면 아래에 댓글 남겨주세요😊

그럼 오늘도 즐거운 하루 보내시길 바랍니다.

고맙습니다 :)

728x90

반응형

'AI & 빅데이터 > 머신러닝·딥러닝' 카테고리의 다른 글

| Multi-label Classification 평가지표: Example-based vs Label-based Evaluation (0) | 2022.07.16 |

|---|---|

| 딥러닝 모델 평가 지표: ROC Curve, AUC Score (0) | 2022.07.15 |

| [딥러닝] Grid Search, Random Search, Bayesian Optimization (0) | 2022.05.23 |

| [딥러닝] 기울기 소실(Vanishing Gradient)의 의미와 해결방법 (12) | 2022.05.22 |

| [딥러닝] 경사 하강법(Gradient Descent) 종류 (0) | 2022.05.21 |