목록Stochastic Gradient Descent (1)

Hey Tech

[딥러닝] 경사 하강법(Gradient Descent) 종류

[딥러닝] 경사 하강법(Gradient Descent) 종류

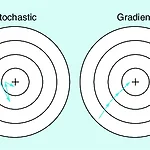

📚 목차 1. 경사 하강법 개념 2. 경사 하강법 종류 2.1. 배치 경사 하강법 2.2. 확률적 경사 하강법 2.3. 미니 배치 경사 하강법 1. 경사 하강법 개념 경사 하강법(Gradient Descent)이란 딥러닝 알고리즘 학습 시 사용되는 최적화 방법(Optimizer) 중 하나입니다. 딥러닝 알고리즘 학습 시 목표는 예측값과 정답값 간의 차이인 손실 함수의 크기를 최소화시키는 파라미터를 찾는 것입니다. 학습 데이터 입력을 변경할 수 없기 때문에, 손실 함수 값의 변화에 따라 가중치(weight) 혹은 편향(bias)을 업데이트해야 합니다. 그럼 어떻게 최적의 가중치나 편향을 찾을 수 있을까요? 최적의 가중치를 찾는 과정을 소개합니다. 최적의 편향을 찾는 과정 역시 절차는 동일합니다. 아래의 그..

AI & 빅데이터/머신러닝·딥러닝

2022. 5. 21. 18:24